In letzter Zeit höre ich immer häufiger Berichte von Onlinemarketern, die sich über die Ungenauigkeit ihrer Webanalyse beschweren. Nicht weil sie Probleme bei der Auswertung haben oder Tracking-Tags falsch implementiert sind, sondern weil Spambots automatisiert auf die Website zugreifen.

Semalt und anderer Referrer-Spam

Anders die meisten der anderen zahllosen Webcrawler, führen diese Bots auch JavaScript aus – also auch die Codes von Google Analytics & Co. und tauchen deshalb auch in ihren Statistiken auf.

Semalt und bfw [buttons-for-website.com] wird in letzter Zeit echt immer nerviger…

– Adrian Berger, Web Analyst bei Immonet

Einer dieser Bots taucht immer wieder in den Google Analytics Statistiken in der Rubrik „Verweise“ auf: er gibt vor, über einen Verweis von *.semalt.com gekommen zu sein. Das Prinzip dahinter ist simpel: Semalt bieten auf ihrer kargen Landingpage ein nicht wirklich näher beschriebenes Tool zur Webanalyse an. Auch wenn ich die Behauptung „yesterday 16478 companies signed up for Semalt“ für absurd hoch halte – grundsätzlich wird das Schema wahrscheinlich funktionieren:

- Grundsätzlich an Webanalyse interessierter User einer eher kleinen Seite schaut sich die neusten Referrer-Statistiken an

- Entdeckt Semalt.com und schaut es sich sofort näher an, in der Hoffnung von dort organisch verlinkt worden zu sein

- Ist interessiert und meldet sich an

Next Level Faking: Relevante Mengen „Traffic“ generieren

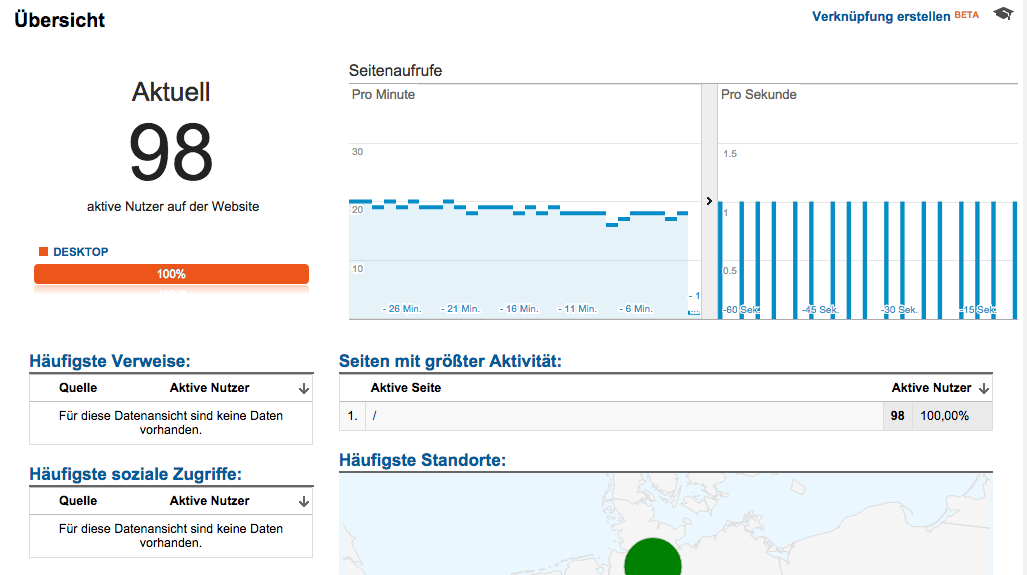

Die paar vorgetäuschten Besucher sind schön und gut, relevant wird es aber erst bei größeren Zahlen. Um grundsätzlich mal zu zeigen wie einfach es ist, Google Analytics-Statistiken zu fälschen hier ein Screenshot aus der Echtzeit-Ansicht

Keiner dieser User war echt. Sie wurden alle durch dieses extrem einfache und kleine Programm simuliert:

Keiner dieser User war echt. Sie wurden alle durch dieses extrem einfache und kleine Programm simuliert:

var url = 'http://www.example.com/';

simulateUniqueVisitor(simulateUniqueVisitor);

function simulateUniqueVisitor(callback){

var casper = require('casper').create();

casper.start(url, function() {

console.log('Neuer unique visitor auf '+url+' generiert')

});

casper.run(function(){

casper.clear();

phantom.clearCookies();

callback(simulateUniqueVisitor);

casper.page.close();

});

}Das ist weder Hexenwerk noch rocket science, sondern simples JavaScript, ausgeführt mit PhantomJS und seinem Wrapper CasperJS. Wer lieber Ruby nutzt, greift auf Capybara und Poltergeist zurück (danke für den Hinweis an Karl Kratz, der die beiden Tools auf dem ConversionSummit kurz erwähnt hatte).

Wichtig ist eigentlich nur: Die Seite und das in ihr enthaltene Tracking-JavaScript muss so schnell wie möglich in einem immer wieder frischen nicht-sichtbaren Browserfenster aufgerufen werden.

Footprints

Diese Methode ist weit weg davon, perfekt gefakte Statistiken zu liefern, sondern ist eher ein proof of concept. Wer gründlich vorgehen will, muss

- unterschiedliche Trafficquellen simulieren (Referrer setzen, um nicht nur als Direkt-Traffic, sondern auch als Verweis oder organischer Suchtraffic eingeordnet zu werden)

- den User-Agent pro Sitzung wechseln, um unterschiedliche Betriebssystem- und Browserinformationen zu übergeben

- mehrere Unterseiten aufrufen und auch Sitzungen auf Unterseiten beginnen

- die Länge der Besuchszeit variieren

- Userinteraktionen wie Scrolling, Hoverereignisse oder Klicks auf Elemente durchführen. Eventuell werden dafür sogar eigene Ereignisse getracked, was den Traffic noch glaubwürdiger macht. Das geht mit wenig Arbeit zum Beispiel mit Gremlins.js

- Tastatureingaben machen, wenn das für die jeweilige Zielseite Sinn macht. Mit Skripten wie TheaterJS kann man sogar dafür sorgen, dass der Text menschlich, d.h. Buchstabe für Buchstabe mit wechselnder Geschwindigkeit und dem ein oder anderen Vertipper eingegeben wird, um maximal glaubwürdig zu sein.

Das ist alles clientseitig (= auf eurem Rechner) ohne größere Probleme machbar. Schwierig wird es bei der IP-Adresse, die sich nicht ohne weiteres fälschen lässt, sodass man auf Proxy-Server zurückgreifen muss. Selbst mit all den eben vorgeschlagenen Verschleierungen, die den Traffic echter erscheinen lassen, würde es sofort auffallen, wenn alle Besucher dem gleichen Standort zugeordnet würden, weil der auf der IP-Adresse basiert.

Zum Testen reicht vielleicht sogar eine kostenlose Proxyliste, für mehr gibt es diverse kommerzielle Anbieter, die auch private Proxies im Hunderter-Gebinde vermieten.

„Ja und?“ oder Mögliche Schadensszenarien

- Die wenigsten Unternehmen haben eine dezidierte Analyseabteilung oder auch nur einen einzelnen Profianalysten. Auch mit offensichtlich gefälschtem Traffic kann man dafür sorgen, dass die restlichen echten Trafficdaten nicht mehr sauber herauszufiltern sind. Das Unternehmen muss seine Optimierungen von da an im Blindflug weiterführen.

- Der Bonus des Inhouse-SEO ist an Zielvorgaben geknüpft, die auf bestimmten Trafficzahlen basieren. Mit ein wenig Faketraffic zur Unterfütterung lassen sich die Ziele leichter erreichen.

- Der Wert einer Website kann durch falsche Trafficzahlen stark beeinflusst werden. Eine Website mit Traffic aber bislang unzureichender Monetarisierung kann großes ungenutztes Potenzial suggerieren und einen hohen Verkaufspreis rechtfertigen bis der hintergangene Käufer merkt, dass der Traffic kurz nach der Überweisung plötzlich wegbricht.

Auch professionelle Website-Broker wie die Empire Flippers schauen sich Google Analytics Statistiken an, um die Validität von Trafficangaben zu bestätigen. Bei gut gefaktem Traffic werden aber auch sie nichts bemerken. - Bei Websites mit TKP-basierter Monetarisierung lassen sich mit Faketraffic die Einnahmen erhöhen. Man sollte es nicht übertreiben, weil viele Vermarkter natürlich ausgefeilte Erkennungsmaßnahmen für solche Manipulation haben. Außer natürlich die Website gehört dem Konkurrenten, dann könnte man es radikal übertreiben und für Stress zwischen ihm und seinem Vermarkter sorgen.

Wenn man bedenkt dass z.B. Video-Ads bei myvideo zumindest im Einkauf einen TKP von bis zu 70 € haben braucht man damit nichtmal viel Traffic, um signifikante Summen zu erreichen. Es gibt immer noch zu viele kleine Märkte auf denen gutes Geld für schlechte Werbung bezahlt wird. - Noch ein Level gemeiner: Mühe geben und der Konkurrenz über Monate oder sogar Jahre hinweg Mehreinnahmen mit Faketraffic generieren. Das Geld wird investiert, Mitarbeiter werden eingestellt und genau wenn es richtig losgeht: Traffic abstellen.

Auf der anderen Seite leidet natürlich auch der Werbetreibende, der die TKP-basierten Ads einkauft. Der Faketraffic konvertiert nicht und die Werbung ist für die Katz. Das bedeutet nicht zwangsläufig, dass er die Anzeigen in Zukunft abschaltet – zu häufig wird Null-Conversion mit den berüchtigten Brandingeffekten geschönt und das Geld weiter verheizt.

Faketraffic muss nicht zwangsläufig automatisch generiert sein. Mit Traffichändlern wie ChokerTraffic oder eBesucher können faule Angreifer schon mit minimalem Kapital die Besucher einfach einkaufen.

Auch der Missbrauch von bestehendem Traffic auf anderen Seiten ist möglich: Webspam-, Warez- und/oder Porn-basiertes Portal mit massig Besuchern aufbauen und die Zielseite im unsichtbaren iFrame laden.

Gegenmaßnahmen

- Schreibe soweit es der Datenschutz erlaubt Server-Logs mit, sodass dir auch im Nachhinein kein einziger Request an deinen Server entgeht. Damit können sowohl Angriffe auf deine Seitenperformance aufgedeckt als auch unterstützende Daten für den Ernstfall gesammelt werden. Eventuell helfen die Rohdaten später dabei, unerwünscht gezählten Traffic aus der Webanalyse nachträglich herauszurechnen.

Um die oft riesigen Dateien auswertbar zu machen ist Splunk eine gute Hilfe. - Benutze die eingebaute Bot-Erkennung von Google Analytics. Die filtert den richtig stumpfen Spam schon einmal heraus und man hat etwas freiere Sicht.

Datenansicht > Einstellungen der Datenansicht > Bots herausfiltern - Baue ein engmaschiges Monitoring für die Serverperformance auf. Wenn sie noch keine haben, sollten deine Sysadmins ein paar Bildschirme im Büro aufhängen, auf denen in Echtzeit Probleme festgestellt werden können. Sollten diese Probleme auftreten, brauchen sie einen kurzen Draht zu den SEOs.

Lege dir Alerts in Google Analytics an, um außergewöhnliche Trafficspitzen so schnell wie möglich mitzubekommen. Auch die Analytics-Realtime-Ansicht auf einem eigenen Monitoring-Bildschirm kann nicht schaden. Beobachte nicht nur den Gesamttraffic, sondern auch die Conversionraten für Mikroconversions. Wenn die Interaktion der User mit der Website drastisch einbricht, kann das ein Hinweis auf schlechten oder sogar gefälschten Traffic sein. - Wenn du im größeren Stil Geld mit TKP-basierten Geschäften verdienst, brauchst du eine fähige Software, die falschen Traffic erkennt. Bezahle deine Mitarbeiter nicht auf Basis von Traffic und denk nach, ob es nicht eine bessere / sicherere Alternative gibt als die Monetarisierung von Werbemittelimpressionen. Faketraffic mag kurzfristig Geld in Kasse spülen, aber wenn Werbekunden halbwegs darauf schauen wofür sie ihr Geld ausgeben, wird auffallen, dass sie es genau so gut verbrennen könnten.

Edit:

Weiterführende Links

- Geek guide to removing referrer spam in Google Analytics mit Fokus auf die Effekte von Fake Traffic auf Google Analytics von Himanshu Sharma (Danke für den Tipp an Florian Elbers)